Det gådefulde, malede smil fra "Mona Lisa" er kendt over hele verden, men det berømte ansigt for nylig viste en forbløffende ny række udtryk, høflighed af kunstig intelligens (AI).

I en video, der blev delt til YouTube den 21. maj, viser tre videoklip foruroligende eksempler på Mona Lisa, når hun bevæger sine læber og vender sit hoved. Hun blev skabt af et indviklet neuralt netværk - en type AI, der behandler information meget, som en menneskelig hjerne gør, for at analysere og behandle billeder.

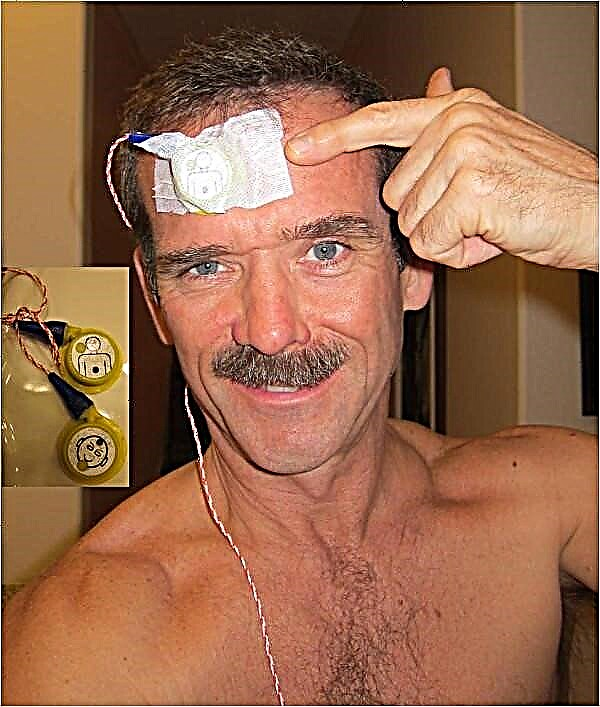

Forskere trænede algoritmen til at forstå ansigtsegenskaber 'generelle former og hvordan de opfører sig i forhold til hinanden og derefter anvende denne information på stillbilleder. Resultatet var en realistisk videosekvens af nye ansigtsudtryk fra en enkelt ramme.

For Mona Lisa-videoerne "lærte" AI ansigtsbevægelsen fra datasæt af tre menneskelige emner og producerede tre meget forskellige animationer. Mens hvert af de tre klip stadig var genkendelig som Mona Lisa, lånte variationer i træningsmodellenes udseende og adfærd forskellige "personligheder" til de "levende portrætter", Egor Zakharov, en ingeniør ved Skolkovo Institute of Science and Technology, og Samsung AI Center (begge placeret i Moskva), forklaret i videoen.

Zakharov og hans kolleger genererede også animationer fra fotos af det 20. århundrede kulturelle ikoner som Albert Einstein, Marilyn Monroe og Salvador Dali. Forskerne beskrev deres fund, som ikke var peer-review, i en undersøgelse offentliggjort online 20. maj i preprint-tidsskriftet arXiv.

Det er ikke let at producere originale videoer som disse, kendt som deepfakes. Menneskelige hoveder er geometrisk komplekse og meget dynamiske; 3D-modeller af hoveder har "titusinder af millioner parametre," skrev undersøgelsesforfatterne.

Hvad mere er, det menneskelige synssystem er meget godt til at identificere "endda mindre fejl" i 3D-modellerede menneskelige hoveder, ifølge undersøgelsen. At se noget der ser næsten menneskeligt ud - men ikke helt - udløser en fornemmelse af dyb ubehag kendt som den uhyggelige daleffekt.

AI har tidligere demonstreret, at det er muligt at fremstille overbevisende dybder, men det krævede flere vinkler af det ønskede emne. I den nye undersøgelse introducerede ingeniørerne AI til et meget stort datasæt med referencevideoer, der viser menneskelige ansigter i aktion. Forskerne etablerede ansigtsmærker, der ville gælde for ethvert ansigt, for at lære det neurale netværk, hvordan ansigter opfører sig generelt.

Derefter trente de AI'en til at bruge referenceudtryk til at kortlægge bevægelse af kildens funktioner. Dette gjorde det muligt for AI at skabe en dyb falskhed, selv når den kun havde et billede at arbejde ud fra, rapporterede forskerne.

Og flere kildebilleder leverede et endnu mere detaljeret resultat i den endelige animation. Videoer oprettet af 32 billeder snarere end kun et, opnåede "perfekt realisme" i en brugerundersøgelse, skrev forskerne.